Nur zwei Monate nach seiner ersten Veröffentlichung erreichte ChatGPT von OpenAI 100 Millionen Nutzer und ist damit laut Reuters die am schnellsten wachsende Verbraucheranwendung in der Geschichte. In den Monaten seitdem haben wir erlebt, dass die KI-Strategie bei Führungskräften zu einer Top-Priorität geworden ist: Laut unserer neuesten Battery Ventures-Umfrage zu Cloud-Software-Ausgaben zählen mehr als die Hälfte der CXOs „Generative KI und LLMs“ zu ihren fünf wichtigsten Prioritäten.

Die zunehmende Einführung von KI hat jedoch auch zu einer verstärkten Prüfung und einem stärkeren Bewusstsein für die potenziellen Risiken dieser Systeme geführt. Der „Black-Box“-Charakter von Deep-Learning-Modellen macht es für Regulierungsbehörden und Verbraucher schwierig, dem zu vertrauen, was sie nicht verstehen.

Vorfälle von LLM-Missbrauch haben in den letzten Monaten bereits für Schlagzeilen gesorgt. Zu den Beispielen gehören Samsungs Verbot von ChatGPT, nachdem ein Mitarbeiter vertraulichen Code preisgegeben hatte, und die Sammelklage gegen den beliebten KI-Kunstgenerator Lensa AI, in der behauptet wurde, dass die App ohne Erlaubnis biometrische Daten von Benutzern gesammelt habe.

Da Unternehmen schnell dazu übergehen, KI in ihre Produkte zu integrieren, stehen sie unter dem Druck der Regulierungsbehörden, die den Aufstieg der KI aufmerksam verfolgt haben, dies ethisch und transparent zu tun. Politische Entscheidungsträger auf der ganzen Welt haben damit begonnen, den Grundstein dafür zu legen, wie verantwortungsvolle KI aussieht und wie sie marktübergreifend gesteuert wird. Unserer Ansicht nach benötigt jedes Unternehmen mit einer KI-Strategie eine entsprechende Strategie für KI-Governance und -Sicherheit – und wir sehen, dass ein neuer Technologie-Stack entsteht, der diesen Bedarf bedient.

Der aktuelle Stand der KI-Regulierung

Aber wie denken die Regulierungsbehörden eigentlich über die KI-Aufsicht? Beamte in der EU gehen schnell vor und gehen mit dem KI-Gesetz, das Gerüchten zufolge im Jahr 2024 in Kraft treten soll, voran. Die Autoren des EU-KI-Gesetzes schlagen einen variablen, risikobasierten Ansatz vor, indem sie eine stärkere „verstärkte Aufsicht“ für „Hochrisiko“-KI-Systeme und nur „begrenzte Transparenzpflichten“ für „Nicht-Hochrisiko“-Systeme vorschreiben. Eine gründliche Dokumentation und Sichtbarkeit von KI-Systemen stand im Mittelpunkt des EU-KI-Gesetzes, um das Design, den Zweck und die Risikominderungsstrategien der Systeme besser zu verstehen. Das EU-KI-Gesetz legt auch die Messlatte für die Konsequenzen von Verstößen fest, mit einer Geldstrafe in Höhe von 20 Millionen Euro oder 4 % des Jahresumsatzes, je nachdem, welcher Betrag höher ist.

Im Gegensatz dazu fehlt es den USA heute an einem föderalen Regulierungsrahmen für KI. Trotz der fehlenden Bundesaufsicht befolgen viele der Unternehmen, mit denen wir gesprochen haben, das freiwillige AI Risk Management Framework des National Institute of Standards and Technology. In Ermangelung verbindlicher Vorschriften seitens der Bundesbeamten greifen Kommunal- und Landesregierungen ein, um die Lücke zu schließen: Das seit Juli 2023 in Kraft getretene Kommunalgesetz 144 der Stadt New York schreibt Voreingenommenheitsprüfungen durch Dritte für automatisierte Einstellungssysteme vor und stellt damit eine eher technische Lösung dar Ansatz als der dokumentationszentrierte Ansatz der EU.

Es wird deutlich, dass viele Unternehmen beginnen, proaktiv über Risiko- und Compliance-Kontrollen rund um den Einsatz von KI nachzudenken, auch wenn sich die US-Bundesregulierung noch in der Entwicklung befindet.

Warum also jetzt handeln? KI, die nicht unter Berücksichtigung von Leitplanken entwickelt wird, kann für Unternehmen weit hinter der ursprünglichen Entwicklung zu kritischen Problemen führen. Zusätzlich zu den finanziellen Konsequenzen, die die Regulierung bald mit sich bringen wird, sind Unternehmen mit einem erheblichen Geschäfts- und Markenrisiko durch KI-Missbrauch konfrontiert. Beispielsweise erfordert KI, die personenbezogene Daten (PII) oder biometrische Daten verwendet, ein erhebliches Vertrauen der Kunden, ebenso wie KI, die in der medizinischen Diagnostik oder im Underwriting eingesetzt wird. Der Missbrauch von KI in diesen Anwendungen könnte nicht nur zu einer Markenschädigung führen, sondern auch negative Auswirkungen auf die Verbraucher haben.

Der aufstrebende KI-Compliance- und Governance-Tech-Stack

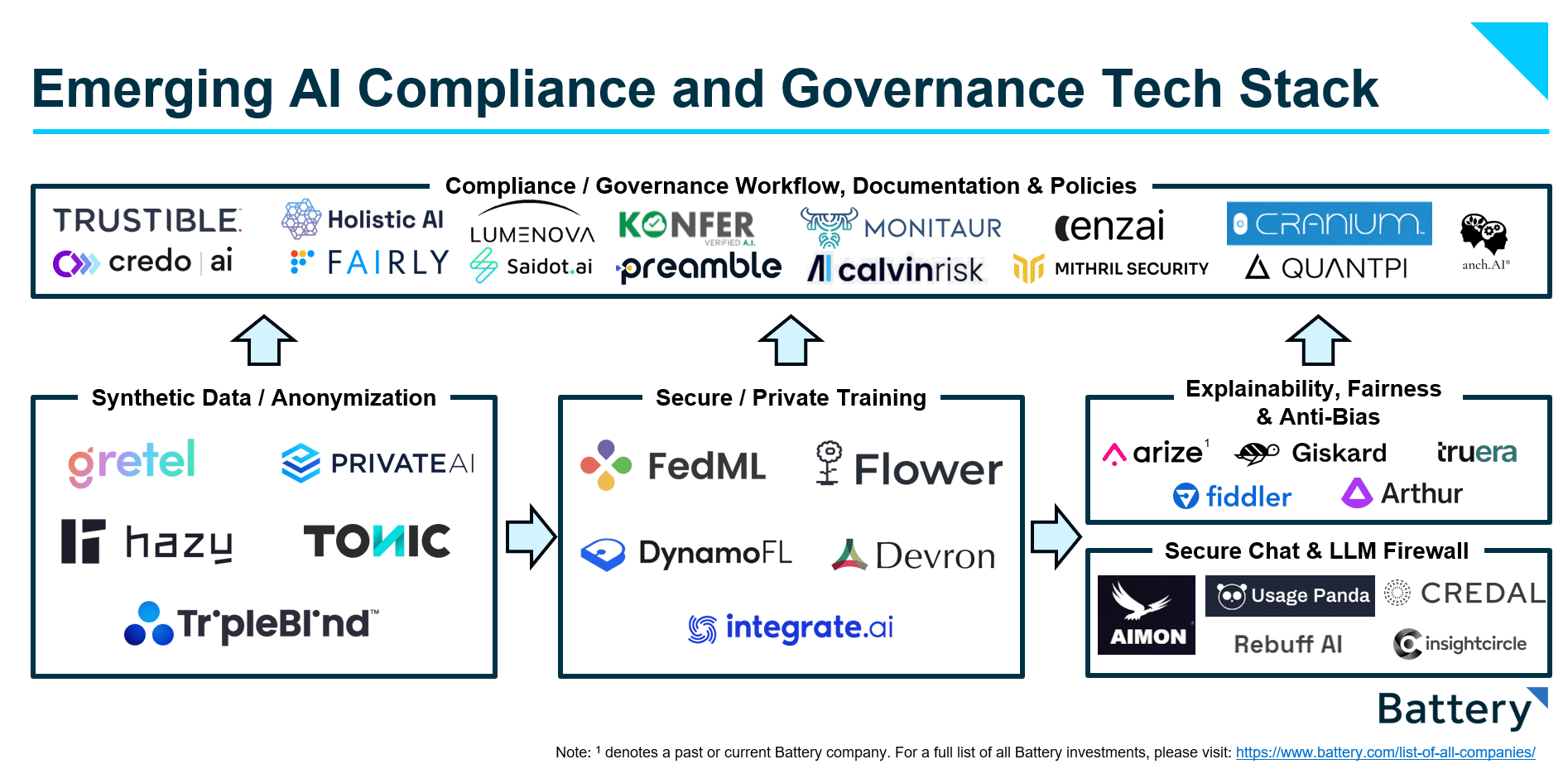

Um diesen bevorstehenden KI-Vorschriften zu begegnen, haben wir einen neuen Compliance- und Governance-Technologie-Stack gesehen, der es Unternehmen ermöglicht, konforme und transparente KI-Systeme aufzubauen, bereitzustellen und zu verwalten. Der ML-Modellentwicklungsprozess hat sich von einem rein technischen Problem zu einem Problem entwickelt, an dem eine Vielzahl von Interessengruppen beteiligt sind, da der Einsatz von KI von Führungskräften, Aufsichtsbehörden und Kunden gleichermaßen zunehmend unter die Lupe genommen wird.

Wir betrachten diesen KI-Compliance- und Governance-Tech-Stack als zwei separate, aber voneinander abhängige Teile:

- Stack für maschinelles Lernen (ML)– Diese Technologie richtet sich an technische Interessenvertreter (ML-Ingenieure, Datenwissenschaftler), die für den Aufbau der Modelle und der Infrastruktur verantwortlich sind, die für die Bereitstellung sicherer KI-Systeme erforderlich sind.

- Governance-/Compliance-Workflow Schicht – Diese Software richtet sich an nichttechnische Interessengruppen (Compliance, Recht, Führungskräfte, Regulierungsbehörden), die für die geschäftliche und regulatorische Ausrichtung von KI-Systemen verantwortlich sind.

Der Infrastruktur-Stack für maschinelles Lernen

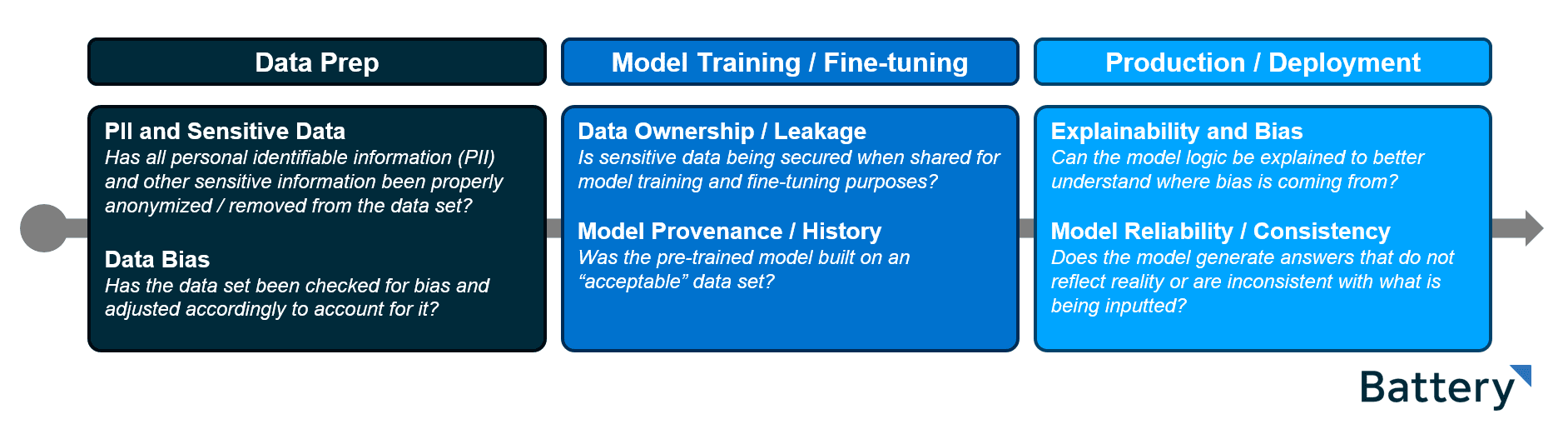

KI-Risiken treten in jeder Phase des ML-Lebenszyklus auf. Das bedeutet, dass Modelle von Grund auf bewusst und auf sichere und konforme Weise entworfen, trainiert und eingesetzt werden müssen.

Bei Battery unterteilen wir den ML-Lebenszyklus in drei separate Schritte, von denen jeder seine eigenen Compliance- und Governance-Risiken mit sich bringt:

Basierend auf unserer Erkundung des Raums haben wir vier Bereiche definiert, die neue Werkzeuge umfassen:

- Synthetische Daten/Anonymisierung (Datenvorbereitung) – Unterstützung von Teams beim Entfernen personenbezogener Daten und sensibler Daten aus ihrem Datensatz und beim Anreichern mit synthetischen Daten, um Verzerrungen zu beseitigen oder redigierte Inhalte zu ersetzen.

- Sicheres/privates Training (Modelltraining/Feinabstimmung) – Nutzung verschiedener Techniken wie föderiertes Lernen und differenzierter Datenschutz, um Unternehmen dabei zu helfen, ihre eigenen Modelle sicher zu trainieren und vorab trainierte Modelle zu optimieren.

- Erklärbarkeit, Fairness und Anti-Bias (Produktion/Bereitstellung) – Bewertung und Überwachung von Modellen in der Produktion, um Bias und Abweichungen zu identifizieren und Transparenz in die Logik hinter den Modellen zu bringen.

- Sicherer Chat und LLM-Firewall (Produktion/Bereitstellung) – Erstellen eines Wrappers oder einer privaten Instanz von LLM-Bereitstellungen, um die Ein- und Ausgänge des Modells vollständig zu überprüfen und Compliance-Anforderungen zu erfüllen. (Dies ist ein Bereich, bei dem wir festgestellt haben, dass er sich auf differenzierte Weise mit der Sicherheit überschneidet, worüber wir gerne sprechen, wenn Sie in diesem Bereich bauen.)

Die Governance-/Compliance-Workflow-Ebene

Zusätzlich zu den in den ML-Stack integrierten Sicherheitsmaßnahmen prognostizieren wir den Aufstieg einer Compliance-/Governance-Workflow-Ebene, die speziell für technisch nicht versierte Geschäftsanwender entwickelt wurde, die KI in Organisationen verwalten. Diese Plattformen fungieren als Aufzeichnungssysteme zur Dokumentation, Verwaltung und Bereitstellung von Einblicken in den KI-Bestand, die KI-Anwendungsfälle und die Projektbeteiligten eines Unternehmens. Viele dieser Plattformen bieten sofort einsatzbereite Leitplanken, die auf bestehende und neue Vorschriften abgestimmt sind, um sicherzustellen, dass Unternehmen die von den Regulierungsbehörden festgelegten Dokumentationsanforderungen erfüllen.

Dies sind die Plattformen für die interne Dokumentation und Berichterstattung über die KI-Nutzung und schließen die Wissenslücke zwischen den technischen Teams, die KI-Systeme entwickeln, und den nichttechnischen Geschäftsteams, die sie verwalten. Durch die Umsetzung von Bottom-up-Modellmetriken und -Artefakten in einfache und verständliche Berichte für nicht-technische Stakeholder können Governance- und Compliance-Plattformen Transparenz und Akzeptanz innerhalb und außerhalb ihrer Organisationen schaffen.

Fazit und Marktchance

Insgesamt sind wir davon überzeugt, dass der von uns beschriebene KI-Governance-Software-Stack eine spannende neue Softwarekategorie und eine große Marktchance darstellt. Vertrauen und Transparenz sind der Schlüssel. Wir glauben, dass Unternehmen weiterhin Software einführen werden, die ihnen dabei hilft, sicherzustellen, dass ihre KI sicher, konform und transparent ist. Wir sind gespannt auf die Entwicklung dieses Marktes und behalten das Ohr am Boden. Wenn Sie KI-Governance aufbauen oder in diese investieren, wenden Sie sich bitte an uns!

*Bezeichnet ein Battery-Portfoliounternehmen. Für eine vollständige Liste aller Battery-Investments klicken Sie bitte hier.

Die hierin enthaltenen Informationen basieren ausschließlich auf den Meinungen von Dharmesh Thakker, Dallin Bills, Jason Mendel, Patrick Hsu und Adam Piasecki und nichts sollte als Investment ausgelegt werden. Dieses Material wird zu Informationszwecken zur Verfügung gestellt und stellt keine Rechts-, Steuer- oder Anlageberatung oder ein Angebot zum Verkauf oder eine Aufforderung zur Abgabe eines Angebots zum Kauf einer Beteiligung an einem Fonds dar und darf auch nicht in irgendeiner Weise als solche herangezogen werden Investmentvehikel, das von Battery Ventures oder einem anderen Battery-Unternehmen verwaltet wird.

Die Informationen und Daten beziehen sich auf den Zeitpunkt der Veröffentlichung, sofern nicht anders angegeben. Inhalte, die aus Drittquellen stammen, werden zwar als zuverlässig erachtet, wurden jedoch nicht von unabhängiger Seite auf ihre Richtigkeit oder Vollständigkeit hin überprüft und können nicht garantiert werden. Battery Ventures ist nicht verpflichtet, den Inhalt dieses Beitrags zu aktualisieren, zu ändern oder zu ergänzen oder Leser*innen zu benachrichtigen, falls sich darin enthaltene Informationen, Meinungen, Prognosen, Vorhersagen oder Schätzungen ändern oder später ungenau werden.

Die obigen Informationen können Prognosen oder andere zukunftsgerichtete Aussagen zu zukünftigen Ereignissen oder Erwartungen enthalten. Vorhersagen, Meinungen und andere Informationen, die in diesem Video besprochen werden, können sich ständig und ohne Vorankündigung ändern und sind nach dem angegebenen Datum möglicherweise nicht mehr zutreffend. Battery Ventures übernimmt keine Verpflichtung und beabsichtigt auch nicht, diese zukunftsgerichteten Aussagen zu aktualisieren.

Ein monatlicher Newsletter zum Austausch neuer Ideen, Erkenntnisse und Einführungen, um Unternehmer*innen beim Ausbau ihres Geschäfts zu helfen.